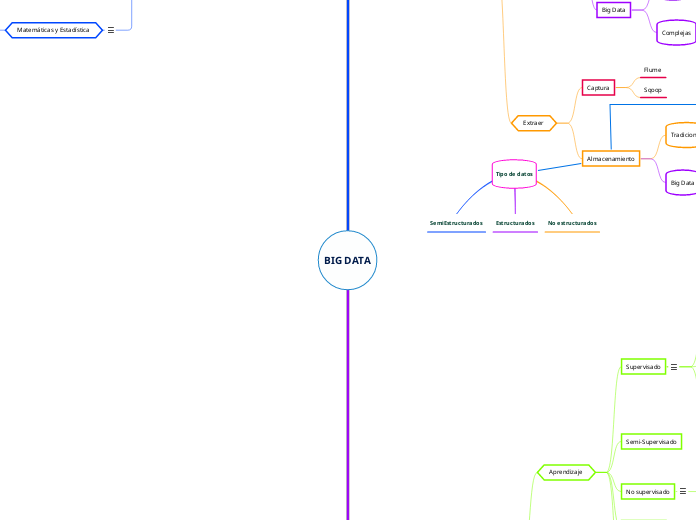

BIG DATA

ETL

Cargar

Tecnologías

Comerciales

SAS

IBM

OpenSource

Spark y Hadoop

Lenguajes de programación

R

Python

Big Data

Simples

Hive

Pig

MapReduce

Complejas

Spark

Extraer

Captura

Flume

Sqoop

Almacenamiento

Tradicional

BBDB Relacional

Ficheros

Big Data

HDFS

NoSQL

Machine Learning

Aprendizaje

Supervisado

Algoritmos de Regresión

Regresión Lineal

Regresión ordinaria por mínimos cuadrados

Regresión Logística

KNN (K-Nearest Neighbor)

Algoritmos de Árboles de Decisión

Árboles de clasificación

Árboles de regresión

Semi-Supervisado

No supervisado

Algoritmos de Agrupamiento (Clustering)

K-Means

Agrupamiento Espectral

Mapas Auto-Organizados

Por refuerzo

Algoritmo por contracción

Regresión Ridge

Regresión Lasso

Elastic

Capacidad

Estrecha(ANI)/Débil

General(AGI)/Fuerte

Super(ASI)

Conocimientos

Experto

Informática

Matemáticas y Estadística

Estadística

Estadística descriptiva

Escalas de medida

Análisis de variables categóricas

Análisis de variables contínuas

Correlación, correlación vs casualidad

Estadística inferencial

Distribuciones

Distribución Normal

Teorema del límite central

Margen de error y nivel de confianza

Alpha y pvalor

Contraste de hipótesis

Conceptos avanzados

Normalidad

Homocedasticidad de varianzas

Linealidad Vs no linealidad

Multicolinealidad

Bootstrapping

Casos de uso

Ejemplo por fases

1. Descubrimiento

Subtopic

Tipo de datos

SemiEstructurados

Estructurados

No estructurados

Teorema CAP

SQL

CA: Consistencia y Disponibilidad

SQL

MySql

Oracle

Maria DB

NoSQL (Not Only SQL)

AP: Disponibilidad y Tolerancia a la partición

Cassandra

Dynamo

KAI

CouchDB

Riak

CP: Consistencia y Tolerancia a la partición

BigTable

Hbase

Redis

MongoDB

NewSQL

ClustrixDB

NuoDB

CockroachDB

TokuDB

Apache Trafodion