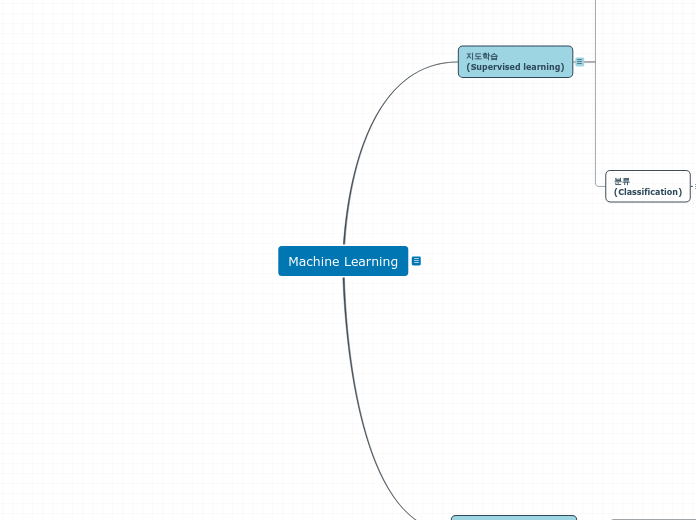

지도학습

(Supervised learning)

회귀

(Regression)

선형회귀

(Linear Regression)

손실(Loss)

평균 제곱 오차( Mean Squared Error )

평균 절대 오차( Mean Absolute Error )

후버 손실( Huber loss )

결정 계수( coefficient of determination )

수렴(Convergence)

경사하강법(Gradient Descent)

학습률(Learning Rate)

다중선형회귀

(Multiple Linear Regression)

데이터 세트 분리하기 (Training & Test)

Training Set

Validation Set

Test Set

교차 검증 (N-Fold Cross-Validation)

모델의 정확도(Accuracy)

잔차 분석(Analysis)

결정계수 R2

분류

(Classification)

K-최근접 이웃

(K-Nearest Neighbor)

정규화(Normalization)

최대-최소 정규화(Min-Max Normalization)

Z-점수 정규화(Z-Score Normalization)

K 선택

Overfitting

데이터 자세히(평균등)

적절하게 수집된 데이터인가?

데이터 보강

데이터에 포함될 특성 제한

Underfitting

두 점 사이의 거리 공식(Distance Formula)

유클리드 거리 (Euclidean Distance)

맨하탄 거리 (Manhattan Distance)

해밍 거리 (Hamming Distance)

가중 회귀(Weighted Regression)

분류 모델의 성능 평가 지표

Accuracy

Recall

Precision

F1 Score

로지스틱 회귀

(Logistic Regression)

Log-Odds

Sigmoid Function

Log Loss(로그 손실)

Classification Threshold(임계값)

서포트 벡터 머신

(Support Vector Machine)

최적의 결정 경계(Decision Boundary)

마진(Margin)

이상치(Outlier)를 얼마나 허용할 것인가

하드마진(hard margin)

오버피팅

소프트 마진(soft margin)

언더피팅

파라미터 C

커널(Kernel)

다항식(Polynomial)

방사 기저 함수 (RBF: Radial Bias Function)

파라미터 gamma

의사결정 나무(Decision Tree)

지니 불순도(Gini Impurity)

정보 획득량 (Information Gain)

재귀적(Recursive) 트리 빌딩

Weighted Information Gain

랜덤 포레스트(Random Forest)

배깅(Bagging)

Bagging Features

나이브 베이즈(Naive Bayes)

Bayes' Theorem

스무딩(smoothing)

비지도학습

(Unsupervised learning)

군집화( Clustering )

K-Means 클러스터링

K-Means ++ 클러스터링